La cybersecurity nell’era dell’AI: come è cambiato il panorama delle minacce nel 2023

Nell’ultimo report gli esperti Kaspersky hanno evidenziato la profonda influenza dell’IA sul panorama delle minacce IT del 2023. Grazie a un approccio su più fronti, l'analisi esplora le implicazioni dell'IA, concentrandosi sul suo utilizzo da parte degli addetti alla sicurezza e delle autorità di regolamentazione e valutandone separatamente il possibile utilizzo da parte dei criminali informatici. Questo approfondimento completo, parte del Kaspersky Security Bulletin (KSB), è una raccolta annuale di previsioni e report dettagliati che evidenziano i cambiamenti chiave nel campo della cyber sicurezza

Con il veloce avanzamento del progresso tecnologico e con i cambiamenti della società, il termine “AI” si è affermato nelle conversazioni globali. Grazie alla crescente diffusione dei Large Language Model (LLM), le crescenti preoccupazioni per la sicurezza e la privacy legano direttamente l’AI al settore della cybersecurity.

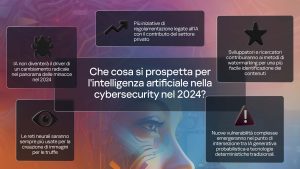

I ricercatori di Kaspersky spiegano come gli strumenti di intelligenza artificiale abbiano aiutato i criminali informatici nelle loro attività malevole nel 2023, mostrando anche le potenziali applicazioni difensive di questa tecnologia. Inoltre, gli esperti dell’azienda mostrano anche l’evoluzione del panorama delle minacce legate all’AI in futuro, che potrebbero includere:

– vulnerabilità più complesse

Con l’integrazione di LLM che seguono le istruzioni su un numero sempre maggiore di prodotti rivolti agli utenti finali, emergeranno nuove e complesse vulnerabilità nell’intersezione tra l’AI generativa probabilistica e le tecnologie deterministiche tradizionali, ampliando la superficie di attacco che i professionisti della sicurezza informatica devono proteggere. Ciò richiederà agli sviluppatori di studiare nuove misure di protezione, come ad esempio l’approvazione da parte dell’utente per le azioni avviate dagli agenti LLM.

– un assistente AI completo per gli esperti di cybersecurity

I red teamer e i ricercatori sfruttano l’AI generativa per realizzare strumenti innovativi di cybersecurity che potrebbero dare vita a un sistema di assistenza che utilizza i LLM o il machine learning (ML). Questo strumento potrebbe automatizzare le attività di red teaming, offrendo indicazioni basate sui comandi eseguiti in un ambiente pentesting.

– le reti neurali saranno sempre più usate per la creazione di immagini per le truffe

Il prossimo anno i criminali potrebbero migliorare le proprie tattiche utilizzando le reti neurali e sfruttando gli strumenti di intelligenza artificiale per creare contenuti fraudolenti più convincenti. Grazie alla possibilità di generare senza sforzo immagini e video convincenti, i criminali informatici rischiano di aggravare sempre più le minacce legate a frodi e truffe.

L’AI non sarà il driver di un cambiamento radicale nel panorama delle minacce nel 2024

Nonostante le tendenze descritte, gli esperti di Kaspersky rimangono scettici sul fatto che l’AI possa cambiare significativamente il panorama delle minacce in tempi brevi. Se da un lato i criminali informatici adottano l’AI generativa, lo stesso vale per gli addetti alla sicurezza informatica, che utilizzeranno gli stessi strumenti, o addirittura più avanzati, per verificare il miglioramento della sicurezza di software e reti, rendendo improbabile un’alterazione significativa del panorama degli attacchi.

– più iniziative di regolamentazione legate all’AI con il contributo del settore privato

Lo sviluppo tecnologico in rapida crescita diventa una questione di policy e di regolamentazione. Il numero di proposte di regolamentazione legate all’intelligenza artificiale è destinato ad aumentare. Gli attori privati, come le aziende tecnologiche, data la loro esperienza nello sviluppo e nell’utilizzo dell’intelligenza artificiale, possono fornire indicazioni preziose per le discussioni sulla regolamentazione in materia di AI sia a livello globale che nazionale.

– watermark per i contenuti prodotti con l’intelligenza artificiale

Per segnalare o identificare i contenuti generati dall’AI saranno necessarie più normative e policy per i provider, che continueranno a investire in tecnologie di rilevamento. Gli sviluppatori e i ricercatori, dal canto loro, contribuiranno ai metodi di watermarking dei media creati dall’intelligenza artificiale per facilitarne l’identificazione e la tracciabilità.

“L’intelligenza artificiale nella sicurezza informatica è un’arma a doppio taglio. Le sue capacità di adattamento rafforzano le nostre difese, offrendo uno scudo protettivo contro le minacce in evoluzione. Tuttavia, lo stesso dinamismo comporta dei rischi, in quanto gli aggressori sfruttano l’intelligenza artificiale per creare attacchi sempre più sofisticati. Trovare il giusto equilibrio, assicurando un uso responsabile senza un’eccessiva condivisione dei dati sensibili, è fondamentale per garantire la sicurezza”, ha commentato Vladislav Tushkanov, Security Expert di Kaspersky.

Questi articoli fanno parte del Kaspersky Security Bulletin (KSB), serie annuale di previsioni e report analitici sui principali cambiamenti nel mondo della cybersecurity. È possibile consultare gli altri articoli del KSB al seguente link.

Contenuti correlati

-

AI generativa per le presse Mecolpress per lo stampaggio a caldo

Mecolpress, punto di riferimento nel settore della produzione di presse per lo stampaggio a caldo di leghe metalliche, ha scelto Userbot.AI, l’agente di intelligenza artificiale generativa made in Italy, per agevolare il Service nelle attività di manutenzione...

-

Le previsioni di Unit 42: Il 2025 sarà l’anno della disruption

Sam Rubin di Unit 42 di Palo Alto Networks analizza e condivide le tendenze di cybersecurity del 2025: “Anno delle interruzioni delle attività”, è questo il termine che contraddistinguerà il 2025, che si presenta come un periodo...

-

SAS Hackathon 2024, un’italiana tra i vincitori

SAS ha annunciato la conclusione del SAS Hackathon 2024, l’evento globale dove data scientist, developer, data analyst, data lovers, tech expert, professionisti e professioniste di ogni settore si sfidano per creare soluzioni innovative a problemi umanitari e...

-

Soluzioni innovative per la supply chain con le soluzioni AI di Panasonic Connect

La nuova divisione europea di ricerca e sviluppo di Panasonic Connect collabora con clienti e partner per creare soluzioni innovative per la supply chain. Lavorando a stretto contatto con la controllata di Panasonic, Blue Yonder, la divisione...

-

Farnell ispira il settore con Top Tech Voices

Farnell ha lanciato una nuova serie di interviste, Top Tech Voices, che con la partecipazione di figure di spicco nel settore tecnologico mettono in evidenza le ultime tendenze tecnologiche con le concezioni più innovative. Nei sei episodi...

-

L’importanza della AI in Transizione 5.0 per il manifatturiero con ally Consulting

Il Piano Transizione 5.0 rappresenta una svolta cruciale per il sistema industriale italiano. A sostenerlo è Paolo Aversa, managing director di ally Consulting. Ancora in fase di definizione, questo piano potrebbe sostituire il precedente 4.0, con l’intento...

-

Infrastruttura cloud e AI generativa con SAP per Prysmian

In soli quattro mesi, Prysmian, azienda di punta a livello mondiale nella produzione, fornitura e progettazione di sistemi in cavo e accessori per le telecomunicazioni e l’energia, ha aggiornato e migrato l’intera infrastruttura IT del Gruppo sul...

-

Investimenti digitali in Italia, +1,5% nel 2025 secondo gli Osservatori del PoliMi

Nonostante l’incertezza economica, le aziende italiane confermano gli investimenti nel digitale, ritenuto essenziale per mantenere competitività. Secondo i dati della ricerca degli Osservatori Startup Thinking e Digital Transformation Academy del Politecnico di Milano, per il 2025 si...

-

Digitalizzazione, IoT e cybersecurity: il nuovo volto del mobile hydraulics

Grazie alle tecnologie IoT, il comparto mobile hydraulics si dirige verso una continua integrazione tra automazione, connettività e gestione intelligente dei dati. Il settore mobile hydraulics sta attraversando una trasformazione senza precedenti. L’integrazione delle tecnologie IoT e...

-

Scopri tutto il potenziale di pylon vTools di Basler

In campo della visione artificiale, pylon vTools di Basler offre funzioni avanzate di elaborazione e analisi delle immagini, basate su algoritmi classici e di intelligenza artificiale. Grazie a un’interfaccia intuitiva, è possibile creare pipeline robuste per applicazioni...